张小军丨关于“人工智人”的认知人类学思考

【作者简介】张小军,清华大学社会科学院社会学系教授、博士生导师,人类学与民族学研究中心主任。研究方向为历史人类学、经济人类学、发展人类学和认知人类学。主要著作有《社会场论》、《让“经济”有灵魂:文化经济学思想之旅》、《让历史有“实践”——历史人类学思想之旅》、《让“社会”有“文化”——人类学自我本土化反省》、《人工智能感官的主体性:感观人类学视角的思考》(论文)等。

【摘要】从认知人类学的视角,对人工智人的发展展开思考,其核心问题可以表述为:人工智人以何为人?何以为人?人工智能的“二次性问题”,本来是人工智人以何为人的基础,目前却成为人类的挑战,甚至挑战着现有的社会价值和结构。在机器通过人工智能走向人工智人的同时,人类在很多方面已经开始受制于人工智能。特别是人工智能带来的标准化、去文化、去主体性,以及最终的去人性,使得人类正在走向人类机器。“文化”是人类社会之脑,一旦人类被人工智能统治,会导致人类按照人工智能的规范去“二次文化”。鉴于此,一方面要约束人工智人,防止其以“科技暴力”统治并“文化”人类;另一方面基于人类学本体论转向的文化认知,不应将人工智人简单视为一种工具,而是应将其当作“人”,约束其成为有文化、有伦理的人。由此才能实现人工智能与人类长久和平共生。

【关键词】人工智能;人工智人;人类学;认知人类学;二次性问题;文化

【来源】《人民论坛·学术前沿》2023年第24期。

问题的提出

“我们的交通工具已经从独木舟变成帆船,变成汽船,变成飞机,再变成航天飞机,但是我们还是不知道自己应该前往的目的地。我们拥有的能力比以往任何时候都更强大,但几乎不知道该怎样使用这些力量。我们让自己变成了神,而唯一剩下的只有物理法则,我们也不用对任何人负责。……拥有神的能力,但是不负责任、贪得无厌,甚至连想要什么都不知道,天下危险,莫此为甚!”[1]

16世纪初人类学在欧洲发端,最初是以人体解剖学对“人”进行理解的。人之所以为人,是因为人体不同于其他生物,这奠定了人类学最早期关于“人”的理解和研究人的学科——体质人类学(physical anthropology)。体质人类学中有关早期的古人类学、人种学以及今天的生物人类学、分子人类学、遗传人类学的研究,都表明了人类的生物和动物属性。然而,这一点正在受到人工智人的挑战。“人工智人(Artificial Intelligence Person, AIP)”指的是无肉身、有智脑的机器人,从某种程度上而言,是当前“人工智能(Artificial Intelligence, AI)”的仿人进阶版。人工智人将人类从肉身中“解放”出来,重新提出了“人是什么”的基本问题。拥有智脑的人工智人在某些方面的能力超过人类,正在并已经改变着人类的生存以及存在方式,甚至正在改变对“人类”本质的相关理解。

最近,谷歌的AlphaFold,在一项极其困难的任务中击败了所有对手,成功根据基因序列预测了生命基本分子——蛋白质的三维结构。它和打败围棋高手的AlphaGo可谓“孪生兄弟”,只是将其人工智能转向了人类科学中最棘手的领域——基因医疗科学。[2]面对这一突破,制造人类似乎已经曙光在即?未来的人类,是否会被人工智人所取代?最近几年,一些世界顶级AI科学家和企业家因为ChatGPT4的出现,联名呼吁限制AI研究。而对AI引发的危险,霍金也早有预见。

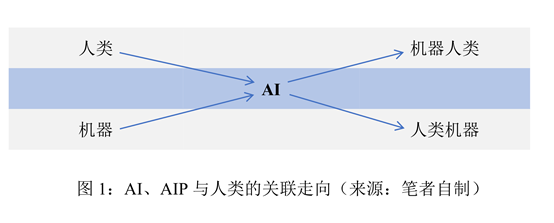

在机器通过人工智能走向人工智人的同时,人类在很多方面已经开始受制于人工智能,特别是人工智能带来的标准化、去文化、去主体性,以及最终的去人性,使得人类越来越走向人类机器。图1呈现了机器与人类通过AI的关联走向。

由此,本文尝试从认知人类学的角度,提出对人工智人/人工智脑的几点思考,其核心问题可以表述为:“人工智人”以何为人?何以为人?

以何为人?——人工智人的“二次性问题”

“以何为人”的问题,是在问人工智人能否成为与我们同样的“人”?凭什么可能成为“人”?进一步的问题是:人工智人有思维、语言和文化吗?

仿人:人工智脑对人脑的挑战。仿人(humanoid)是人工智能的基本出发点,在人工智人的发展中,人的思维、意识和语言等能力一直是其追求的目标。骆利群总结了人脑与智脑的区别,发现人工智脑(Artificial Intelligence Brain, AIB)在速度和精度上超越人脑。[3]笔者尝试整理比较了AIB和人脑的能力,如表1所示。

表1表明,AIB只有两个方面,即运算速度和精度,远远高于人脑,其他能力都弱于人脑。比较而言,人脑的优越性十分明显,但AIB也在迅速追赶。比如,人脑比计算机慢1000万倍(将来相对量子计算可能要慢亿万倍),却为何如此高效?人类大脑由大约1000亿个神经元组成,并由约100万亿个神经突触连接。[4]大脑的一个显著特点是以并行方式执行任务,而计算机主要是以串行方式。不过,学习人脑使用并行多核处理器已经是现代计算机设计的趋势。大脑的另一个显著特点是神经元之间的连接强度可以根据活动和经验进行修改,重复训练使得神经元网络可以更好地执行任务。这也带来人工智能领域的“深度学习”这一重要分支和方向,即采用多层结构来表示越来越抽象的特征(例如视觉过程),通过机器学习来调整不同层之间的连接权重,而不再依赖工程师的设计。不过,大脑依然比先进的计算机更具灵活性、泛化和学习能力。尽管如此,超高的速度、数量度和精度依然带来了AI超高的数据处理能力,并产生了相应的超级脑力。AIP已经对人类提出了全面的挑战。

第一个挑战来自“思维”。思维是什么?这是理解AIP的基础。人脑是人的信息处理器,在数亿年的生物进化中,面对周围复杂的世界,生物体逐渐形成了独特的信息处理器官,包括现在仍在不断进化的人脑。所谓“思维”,就是人脑通过处理信息获得“秩序”的信息动力学过程。例如人观察到山川河流,给它们以概念,同时建立起与自身的联系,形成了关于山川河流的理解和文化意义编码,这就是思维的过程和结果。人脑通过信息处理,即通过思维和认知来建立人与人、人与自然的行为秩序。AIB本身并不会完全像人脑一样感知与处理信息,但是可以通过学习人脑的思维,获得二次思维。

第二个挑战来自“意识”。意识是来自人脑的一种能力,AI可否有意识?2023年10月,《神经科学趋势》发表论文,认为AI系统抽象了生物过程,因此现有AI系统可能已经抽象了意识本身,困在无休止的模拟意识特征,却不得意识之要领。[5]而在2023年8月,图灵奖得主Y. Bengio等人曾论证了人类要想构建有意识的AI系统是完全可能的。[6]同时他与另两位图灵奖得主G. Hinton及姚期智在23年10月联合重磅发文,提出降低AI带来的伤害和风险。[7]一般来说,“意识”是一种信息方式的存在。AI用算法,人脑有神经系统,但这只是表面现象,因为AI也可以仿人来做神经网络。两者的关键区别是:人有自主意识,即自己根据需要进行“意识”的过程;而AI是仿人的学习能力,是训练出来的非自主意识。通过“思维链(chain-of-thought)”可以不断训练模型,使AI学习人的思维方式,形成“意识”。但即便如此,这也是“二次意识”。

第三个挑战来自“语言”。AI的语言能力已经由ChatGPT4给出了答案:在自然语言方面,其至少不输人类,甚至可以超过一般人类;具有自然生成的语言能力,如写报告、论文甚至小说和诗歌;可以自由地与人对话。这其中包括情景学习、思维链、自然指令学习等,都需要人的参与和仿人的学习机制。ChatGPT是对现有网络语言秩序的归纳性处理,其行为是“为语言而语言”的标准化的“二次语言”,而不是为人类交流和有新意的创造活动而语言的。不过,随着大语言模型(Large Language Model, LLM)的完善,其语言智能将超过一般人类个体,极大改变人类之间以及人与物的交流方式,甚至可以引导和改变未来的人类语言,形成“AI语言反噬”。这带来了有关ChatGPT的终极之问。[8]也引发了其“二次语言”的问题。

第四个挑战来自“文化”。文化的本质是人类社会的意义编码体系,是人类社会的信息致序机制,相当于“人类脑”,帮助人类构建社会秩序。人类从小就在不断的“文化化(culturalization)”过程中。AI可以学习语言,但可否学习文化?上述问题,人文与科学主义有着截然不同的出发点,周剑铭、柳渝尝试用科学/人文的二分框架来解决人工智能深层次问题。其中提到“阿尔法狗(AlphaGo)”的原理性局限,认为围棋是文化的行为,而“狗”没有文化。[9]“阿尔法狗”的围棋只是将围棋的输赢进行了所谓的智能化,不可能取代人类有文化的围棋游戏和在其中的文化享受。不过,AI带来的广泛文化影响已经是事实。如有文章探讨人工智能创造宗教的互联网文化基因(meme),其所带来的高可视度的文化产品反映出新的宗教及其背后的人文主义叙事。[10]更有甚者,有研究探讨了由于人们对此身生活的局限而感到沮丧,于是期待一个虚拟世界的彼身,虚拟世界由智能机器和离开自己身体的人类居住。将自己的意识下载到机器中后,人类将拥有增强的心智能力,并通过其无限的可复制性而不朽。[11]人类逃避现世而变成AI人类,由此改变现世的伦理和文化逻辑,这已经成为一种想象。也由此带来了“二次文化”的问题。

第五个挑战来自“情感”。情感是当今AIB研究中最令人沮丧的领域,甚至让人无从下手,因为不知情感从何而来。不过,AI依然可以与人进行情感互动,通过音乐、舞蹈、绘画、电影、艺术等带来情感知觉,包括兴奋、愉悦、哀愁、凄凉,等等。但这只是人的单向感受,且在对同一内容(例如同一首音乐)的“集体狂欢”中,人们的细节感受也是不同的,是多样性的。而这种在日常中众多方面的不同,恰恰是构成相同体验对话的重要基础,这是因为正是人们日常的差异,才有找到共鸣的狂欢和不同“同类”的情感真谛。如果情感被AI不断标准化,则将没有情感可言。悲剧在于,即使没有AI,我们的情感也在物欲中被物化,由此带来标准化的“二次情感”。

第六个挑战来自“生命”。一篇关于全球首个“数字人类”的报道记述了一位名为卡普兰(A. Kaplan)的自然人希望自己所爱的人在他过世后能够接触到他一生的故事,于是同意成为数字人“AndyBot”,这样他将在云上永生。类似地,弗拉霍斯(J. Vlahos)于2017年创建“Dadbot”,是在他得知父亲即将死于癌症,于是想利用AI让父亲“永生”。在父亲生命的最后3个月,他将与父亲就各种话题的谈话、讲述用摄像机录下来,记录了91970个单词,训练出一个对话AI——“Dadbot”。由此他可以与逝去父亲的计算机化身交换文本和音频信息,谈论他的生活、听歌、闲聊和说笑。[12]“AndyBot”和“Dadbot”提出了人的不朽的本质和存在目的之复杂哲学问题,是否意味着“二次生命”的来临?

人文主义和科学主义是理解人工智能的两种不同视角,人文主义的极端视角认为人工智脑是反人文、反人本、反人类的;科学主义的极端视角认为人工智脑是可以全面替代人类的,特别是ChatGPT的出现,更令人误以为人工智脑无所不能。新的人工智能理论更强调智能主体(agent,能动者)是一个有自主学习能力的主体。这些理论多是注重AI的表面机器行为方式,而忽略了人脑的思维、语言、情感、文化与生命过程,尚缺乏文化主义的视角,即缺乏人类脑及“文化”的视角。“文化”作为人类社会之脑,其所进行的复杂信息处理的本质,是构建人类社会的秩序。重要的是,人脑不是为秩序而秩序,而是以人类生存为目标,是不断寻找最优的人类秩序。这其中,必然涉及人类的伦理价值,必然有情感存在其中,必然是长期的文化积累。这是目前AI还难以突破的。

人工智人的“二次性问题”。由上述讨论,可以提出AI的“二次性问题(Quadratic problem)”。所谓“二次性(Quadratic property)”,是指AI的上述所有能力——思维、意识、语言、文化、情感、生命,都不是AI本来的存在属性,而是机器仿人的结果。表面上,AI只是人类发明的新工具,“二次性”似乎是常识。不过,随着AIP逐渐逼近、融合甚至超过和取代人类,这个问题已经变得十分严峻。

论及人脑与AIB的基本区别,人们可以说出脑结构、脑神经系统、信息处理方式等方面的不同。而从人类学的角度看,两者主要是文化认知方式的不同。限于篇幅,这里只讨论一个最基本,也是人类学中最重要的概念:经验。

从人类学(而非哲学)的角度,经验是人脑处理复杂信息的主要方式,是在数十万年中人脑处理信息能力不断进化的结果,它既不是AI算法,也不是大数据的统计。无论思维、意识、语言、文化,等等,本质上都是经验的。因此可以广义称之为“经验智能”。经验智能是人们生活的主要智能,是直接智能。人工智能虽然有算法,但很大程度上是以人类的经验来仿人的,本质上是一种二次经验智能,是间接智能。在认知的意义上,“经验”是一种借助感官进行信息采集,再通过大脑进行信息加工的动力学过程。人文科学就是一门“经验的学科”,人类学尤其如此。社会学虽然有数理统计方法,但是也离不开经验,统计事实可以说是基于人类经验的数学抽象。康德(Immanuel Kant)在《纯粹理性批判》中,讨论了“经验”和“数学”两种思维,认为经验的原理和数学的原理都是来自人们经验(经验在此为动词)事物之前“物自体”本身的规则和秩序。[13]人类学家特纳(V. Turner)更对经验的重要性直言不讳:“对所有人文科学和研究来说,人类学是最深厚地植根于调查者的社会和主观经验之中。每件事情都来自自我的经验,被观察的每件事情最终都是按照他(她)的脉搏而跳动。”[14]

经验本质上是人脑处理信息能力之结晶。目前所有的AI算法本质上也是经验算法。无论是图像识别,还是ChatGPT,本质上都是以人类的“经验能力”为基础的。从人脑的信息动力学内涵探讨人脑的“经验”对于智脑的本质性影响,这可被称为“人工智能的经验主义”:经验是人脑认知世界(信息处理)的主要方式。人工智能的本质是人类的经验智能,是对人类经验认知的经验学习和经验计算,是一种“二次经验”。人类经验的本质是文化的。智脑的二次经验目前只能模仿性学习人类行为,还无法理解性学习行为背后的文化。

具体来说,人脑在处理信息中存在“经验”和“算法”两种基本的思维运行方式,并由此延伸,形成了“人文(经验的)”与“科学(计算的)”的分野,两者都是人脑的存在及其产物。人工智脑的运行来自在表层将经验思维和计算思维的结合,但是在深层,依然是以“二次经验”为主的智脑思维。“二次经验”为主的智脑思维与人脑思维的根本区别在于,前者“没文化”,而后者有。智脑以其所谓的“科学技术”对人类进行标准化的“去文化(de-culture)”。甚而,智脑可能超越人脑,人工智人可能超越人类,最后反噬人类。

进一步看,从人脑作为信息处理器的基本信息处理的文化方式出发,人脑的信息处理可以分为两个并行的基本部分:冷思维与热思维。前者对经验信息的处理是直接分析与处理,没有社会温度,AIB比较容易达到;后者包括了社会伦理道德、情感、文化等影响,AIB很难模仿。处理信息的“冷思维”,主要包括经验思维和计算思维。经验思维是人类基本的思维方式,也是人文科学的基础思维方式,自然科学同样是人脑的认知结果,包括经验思维和计算思维。这样看,人文和自然科学都是人脑的思维活动结果,区别只是两者以不同的思维方式看世界。有社会温度的“热思维”与冷思维不同,是以伦理道德规范、情感等为基础的文化思维。其本质是建立良好的人类秩序,而不是强化某种人脑的能力。

人是有“人性”的。人性中基本的理性、情性、感性、习性及其延伸出的真、善、美、爱的价值追求、道德伦理,以及信仰,等等,机器人可以产生吗?可以自己生成吗?答案是不行。人性,绝非简单的物理和生物构造。一个人的“人性”是在其一生中铸就的。最重要的是,人性是不能通过简单学习得来的。目前机器人被训练出了高水平的学习能力,但是爱情可以“学习”而来吗?信仰可以“学习”而来吗?答案也是不行。一个人因为某个偶然的反应而“一见钟情”,因为一个偶然的闪念灵动而皈依,这都不是学习来的,而是一种嵌入身体生物学系统(神经等系统)的信息动力学机制。

人类为什么会生成情感、思想、伦理?因为这些是人类生成秩序的需要。秩序(包括特纳所言的“离反秩序”——anti-structure)是万物的自然追求。人脑最终遵循的是自组织信息动力学,情感、思想、伦理都是这个自组织信息动力学机制的产物。为什么这样说?因为人伴随着宇宙的演化,生成了许多“元秩序”,人脑作为信息处理系统,就要满足这些秩序。情感,是建立秩序的一种机制;思想,是选择、适应、改变秩序的一类思考;伦理,是维系秩序的一种方式。人工智人还做不到“情感智能”、“思想智能”和“伦理智能”。比如弗洛伊德所说的“libido”(性力、欲力),其中包括了爱和性。爱是人性,爱需要有他人,需要有社会。AIP没有充分的社会性生活,没有家庭生活,如何产生爱。因此,AI只能模仿情感表现的表面行为,并不能真正生成情感。人脑如果没有他人、外界信息的刺激,就不会有语言能力,“狼孩”就是例子,而机器人与狼孩一样也没有必要刺激。同样,因为有性的成长,才有了人的老幼之别、“生死之恋”、男女之分,才有了家庭婚姻和亲属制度。因此人工智人没有性,从根本上就不可能具备情感、伦理,而只能最多是表面的、标准化的行为模仿。有报道说某国家有人与AIP做夫妻,你当然可以爱一个AIP,但是它只会用算法和二次经验来“爱”你,也难有爱的情感涌现(一见钟情)和复杂的、个性的、深度的情感表达。

几年前,笔者发表了《人工智能感官的主体性:感观人类学视角的思考》一文,论述了各种感官的人工智能带来的AI的“二次经验”、标准化以及“去主体性”“去文化”等问题。[15]以视觉为例,AI的图像识别实质上不过是众多常人识别的经验大数据分析之结果。这些经验算法是否能得到人类经验的真谛,是否符合人们的真实经验?答案是否定的。目前的图像识别只是对图像对错的判断,基本不能涵盖不同人对同一图像的不同情感、不同经历带来的不同感受以及不同文化意义上的不同理解。ChatGPT4的出现,似乎改变了上面的很多结论,其实不然。伽达默尔(Hans-Georg Gadamer)在《真理与方法》中提出,“人是一种语言的存在”[16],强调语言信息在人类沟通和建立社会秩序中的基本作用,甚至认为语言就是人的存在本身。ChatGPT4把“人的存在”重新定义,让人类有些不知所措。通过超强的“经验组合”与编辑能力,ChatGPT4似乎可以具有很多“文化行为”,例如写报告、写小说、编故事。但是,人们忘记了人还有一个更重要的存在——“人是一种文化的存在”;同时,文化也是人的存在本身,人必然是“文化人”。ChatGPT4局限于语意的放大和创造能力,这远不是文化信息及其生成秩序的能力。ChatGPT4本质上还是语言的二次经验,只是在信息处理能力上有了飞跃(“涌现”产生),形成了一种高水平的超常人的大数据二次经验。

对于人类学来说,经验本质上是文化的,没有不文化的经验。[17]由此,AI的二次经验,也是“二次文化(second culture)”的。但是,AI的二次文化,有些是对一次文化的异化,如科技暴力就是对原文化的“文化强暴”。人类一直强调善用科技,防止科技发明带来的反人类的科技暴力,然而AI科技暴力却越来越肆无忌惮,甚至AI武器也被大量生产。鉴于此,我们有必要回到原来的文化基点,赋予AI以人的健康文化。

何以为人?——人类的文化本质

“何以为人”,是问机器人智脑有“人性”“思想”“信仰”“伦理”吗?其最终的问题是,智脑有“文化”吗?如果没有,他们“何以为人”?

人工智人的文化归宿。“文化”是人类的意义编码的运行软件系统,也是人类的秩序和致序过程。人类文化是衡量AIP能否为人的最基本层面。人类与AIP之争,最根本的不是思维能力之争、语言能力之争,而是文化之争。笔者曾经给出如下“文化”定义:文化是人类遵照其相应的自组织规律与社会及其周围事物的各种联系,运用信息进行秩序创造并共享其意义的具有再生产性的复杂编码体系。

简言之,“文化”是人类社会之脑,自组织的自发有序是人类秩序之母。文化中蕴含了思想、情感、信仰等复杂的信息能力(文化本身的信息过程就包含了经验和动力学两个方面),这些能力不可能像AI一样单独产生。没有文化经历,人们不可能产生这些复杂的信息能力和结果。危险的是,一旦人类被机器统治,会导致人类文化按照机器的规范建立。所以,一方面,要防止被AIP(通常借助某些权力)统治并“二次文化”人类;另一方面,要限制AIP,让其有文化。

金观涛曾从“科学与人文”的视角,强调当前这场人工智能革命实质是对“智能”认识的某种退步,AlphaGo的工作原理是仿生学,而人类智能的内核——创造并使用符号的能力却遭到忽视。究其原因,这是现代社会中人文精神丧失与科学被技术异化的恶果。人类智能不同于生物本能之处在于,人不仅具备选择的能力,还具备创造符号以及利用符号系统把握世界并赋予世界意义的能力。[18]

AI对人类的标准化、去主体性、去文化,是颠覆人类的根本性问题。笔者曾对机器人与人类的感官经验进行比较,分析两者感官经验的生成方式以及基于感官经验的与外部世界互动的方式,由此理解机器感官与人类感官的根本区别与关联。机器人的“感官经验”将人类单一感官处理物的信息的经验抽离出来,是“去文化”“标准化”的计算产物。理解机器人感官与人类感官的根本区别在于“文化”,人类的身体感官是以高聚能、低能耗的最优秩序为原则而进行感知的。[19]

AIP无文化,却可以有“二次文化”,还可以对我们进行二次文化,当然也可以被我们“文化”。有学者从麦克卢汉的“媒介延伸论”看人工智能威胁论,认为人工智能消除主客界限,是人类的延伸,没有威胁。[20]问题在于,既然人工智能可以消除主客观屏障,成为人类的延伸,也就意味着可以延伸人类之恶。因此,赋予人工智人以人类真善美的伦理文化,而不是邪恶、丑陋、奴役人类的伦理文化,这一点至关重要。

同时,AI可能会使人类失去创造力。ChatGPT是对自然语言进行标准化的典型——只要是同样的提问,便会得到同样的结果。它让人们的伦理判断“失聪”,因为标准化的ChatGPT让人误以为,只要是大多数人的说法、做法、看法,就是对的。AI永远不具备真正的文化能力(但可以模仿文化行为),而人类一旦被AI标准化,也会丧失文化能力。AI的创造力表面上似乎不亚于绝大多数人的想象力,但是实际上,AI带来的生活多样性的丧失正在把人类变成机器。此外,AI还让人们之间的信任变成了“技术信任”或“机器(制度)信任”。但是,人们还未意识到,技术信任会降低人与人之间的直接信任,改变人类的信任生态。

人工智能领域有关“常识”的讨论很有意义。人们在日常生活中依赖“常识”而行为。现实中,机器的常识是人给予的,而人的“常识”首先是经验的,其次必然是文化的。在人类学中,“常识”主要指日常生活的知识。常识的形成本身就是一个文化的经验过程,没有不文化的常识。有什么样的文化,就会引出什么样的“常识”,并不存在孤立的“常识”。但是,机器人的常识背后是没有文化的,其只是通过大数据来模拟计算出一般的常识,是“标准化”的常识,完全不能进行真实人类的替代。

从技术上看,AI超越一般人的某些能力完全不成问题。人类从制造工具开始,就已经在创造某方面能超越自己的东西。在技术决定论的进化论者眼中,人类的演化历史就是工具的演化历史。[21]那么,AI,例如ChatGPT4(如果)超越人类,是否会给人类带来灾难,是否可以被理解为一种AI“原子弹”?笔者认为,AI已经不是如原子弹一般的“工具”,而是在成为人、取代人。其杀伤力不是瞬间的冲击波,而是缓慢的文化信息波——通过改变人类文化而让人类“堕落”。例如,取代人类工作而造成大量失业,帮助抄袭“开绿灯”而导致道德败坏,非法获取商业机密、个人信息和隐私数据等而侵犯他人权益,等等。

因此,其一,所有人工智人的控制软件都应该加入相关的伦理程序甚至法律程序,要有“人”的责任代码。其二,AI有关的法律问题,可以通过立法来解决。如我国公布实施了《生成式人工智能服务管理暂行办法》,旨在促进生成式人工智能健康发展和规范应用,维护国家安全和社会公共利益,保护公民、法人和其他组织的合法权益。其三,AI的相关伦理问题,如ChatGPT4是否应该让资本赢利而让大量人员失业,是否应将其用在教育上而阻碍学生自身写作等能力的形成,这些根本上还是人类社会的文化问题——AI何以为人的问题。

AI的“去文化”“去人性”等特点,可能令人的主体性、主体意识弱化甚至丧失,带来教育标准化、劳动能力退化、认知能力退化、身体能力退化。AI思维、AI语言、AI文化的“灾害”包括:盲目标准化的教育、丧失劳动力的市场、泯灭创造力的设计、忽视多数人的信仰、缺乏多样性的生态、抹杀独立性的思想,等等。前有心理学研究支持抖音等推荐系统带来个性和多样性的结果。[22]后有清华大学团队在《Nature》子刊《Nature Machine Intelligence》上发文,讨论网络推荐系统这类软件如何制造“信息茧”,如何使人们作茧自缚——表面上有个性的多样性推送如何使人类在与AI的日常互动中逐渐失去信息的多样性,而被困于“信息茧房”之中。[23]还有社会学家提出,算法的背后是一个商业的资本逻辑,商家利用人们的消费习惯和倾向,通过算法进一步刺激消费,结果消费行为不自觉地被商业引导而发生改变。[24]不管是“信息茧房”,还是“算法控制”,实质上都是AI反身训练人类和赋予人类“二次文化”,放大人类不良文化的典型。

在人类学领域,已经有学者思考“机器人公民”的概念。陶庆曾专门讨论新政治人类学与“类人机器人”猜想,包括“机器人公民”工具性与自主意识、“机器人公民”公共性与社会责任。[25]现实中,索菲亚作为历史上首个获得公民身份的机器人,在被询问“你想毁灭人类吗”时,其在片刻的面无表情后立即回答“我将会毁灭人类”。很多人对此提出抗议,其中包括马斯克,他认为人类应该限制机器人,不然不受限制的人工智能在未来极有可能成为人类的大患。[26]因此,亟需给AIP以伦理和法律等约束,即把AIP当作“人”,而不是工具,应让AIP与人一样,有伦理、有文化。

法国著名思想家莫兰(Edgar Morin)认为,鉴于科学固有的两可性,我们知道它所产生的新能量既可以被用于行善,也能被用于作恶。[27]正如沃伊切霍夫斯基所言:“科技在取得成功的同时也失败了。成功在物质上,失败在道德上。”人工智能的发展可能将人类从一些职业的束缚及其所属的任务中解放出来,但是,尽管这样也无法回避一种假设,那就是人工智能摆脱了伺服装置的控制,反过来变成控制者。更何况它在一定程度上已经成为资本和权力的工具。从人类学的角度看,伦理并非人类的终点,而是人类的起点。一般来说,人类社会有三种所谓的规范,第一种是伦理道德,第二种是民规民约,第三种是法律规范。从规范的强制性上看,从第一种到第三种依次增强。人类学所研究的初民社会是没有法律的,初民使用伦理道德和民规民约就可以建立良好的社会秩序。随着现代社会问题增多,人们才开始使用强制性的法律。但是,没有伦理道德的社会,法治是不可能实现的,或者只能是扭曲的实现,甚至成为少数人的权力和利益工具。在这个意义上,伦理是人类社会良性运行的基础,也同样应该被赋予人工智人,因此应开展人工智人的伦理制度建设。

基于人类学本体论转向中的文化认知,最重要的是把AIP当作“人”,而不是视其为一种工具。近年来,人类学的本体论转向成为热潮。拉图尔(Bruno Latour)提出“行动者网络理论(Actor-Network Theory, ANT)”,抹消了人与“非人”的界限,[28]后又提出人与自然的“对称性人类学”,都是在去人类中心。[29]进一步,卡斯特罗(Eduardo·Viveiros de Castro)的“视角主义(perspectivism)”将尼采(F. Nietzsche)的相关概念引入人类学的研究,并基于“视角主义”研究美洲大陆原住民,强调“多元自然主义(multinaturalism)”[30]笔者认为,去人类中心的本体论转向其实蕴含着两个方向,即平等原则下“都视为物”或者“都视为人”,也即皆为agent(能动者)。过去,我们把AIP当作科技工具,与人分离,于是,产生了“科技暴力”。现在,我们要把AIP当作“人”,让其承担作为“人”的社会义务以及伦理道德和法律责任,这样才能让AIP更好地为人类服务,促进人类和平、幸福、美好的文化前景,而不是相反。

从文化思考人工智人:认知人类学角度。自然界超越人的能力者千千万万,植物、昆虫、动物,都有过人之处,人类唯一的优势是人脑。但是大家忽略了另一个“唯一”,那就是群体人类的社会脑——文化。人类学家认为,在进化的链条上,文化是人类唯一与动物的不同之处。对于文化脑来说,无论是人文经验还是科学计算的能力,最终都是一种文化能力。人类不可能有无文化的人文经验,也不可能进行无文化的数字、符号和公式的计算。文化是人类脑信息处理的起点、过程和结果,也是人类认知进化的结果。古迪纳夫(W. H. Goodenough)清楚地表明了认知人类学的文化观:文化系统将个人的认知世界与个体意识和行为联系起来形成社会。所谓文化,就是个人的认知世界相互关联而形成的解释模式,即围绕某个社会的知识体系形成的观念模式。[31]

与人工智能研究最为接近的,是认知科学(cognitive science)。有人类学家,如格尔兹(C. Geertz)曾对认知科学提出批评,“最近随着认知科学发展起来,有一种趋势出现了:文化和心灵这两个术语几乎完全被巧妙打发,代之以谈论神经回路和计算加工、接受人工智能的可编程系统——这个策略让思想的社会居所问题和意义的个人根基问题都不被触及也不可触及”[32]。这一批评十分犀利,提醒认知科学的发展不应该走向“科学主义”,而应该走向“文化主义”,因为认知科学最终应该为人类服务,而不是为“科学”作脚注。类似地,对于人工智能而言,取“文化主义”而非“科学主义”,从某种程度上说也同样是“应然”和“必要”。

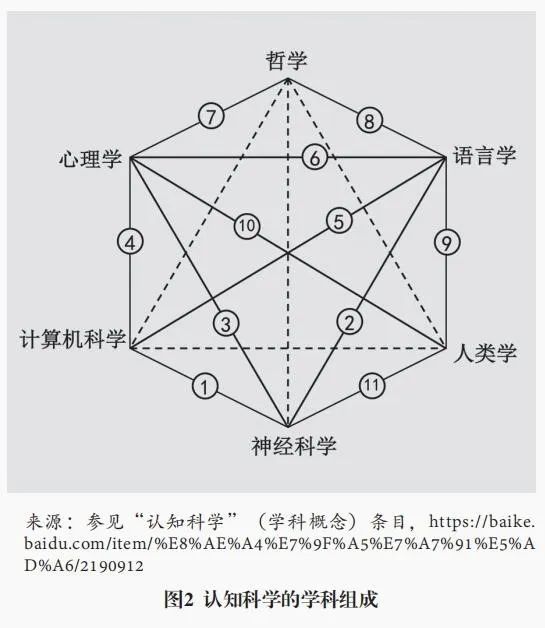

认知科学包含了与人工智能相关的所有主要学科。其学科组成如图2所示。认知科学有6个基础支撑学科:神经科学(脑)、计算机科学(信息)、哲学(思维)、语言学(语言)、心理学(意识)和人类学(文化)。其中4个是人文核心学科,即认知哲学、认知语言学、认知人类学和认知心理学,这些正是与人工智能相关的主要研究领域。此外,认知科学还包括11个交叉学科:脑神经信息科学(脑-机交互)、神经语言学、神经心理学、计算心理学(认知计算机仿真)、计算语言学(智能语言)、心理语言学/语言心理学、哲学心理学/心理哲学、语言哲学/哲学语言学、语言人类学(社会语言学)、心理人类学/文化心理学、脑进化/脑人类学。另外,还可补充4个交叉学科(如图2虚线所示):哲学/伦理人类学、AI和信息哲学、文化信息学/AI人类学、脑哲学。可见,人类学构成了认知科学多个扩展交叉学科的基础与支撑,而认知人类学为认知人工智人带来了新的视角。

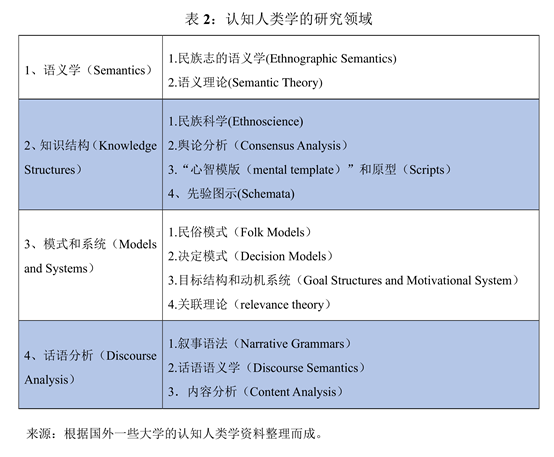

认知人类学作为人类学的一个分支学科,与心理认知、语言认知等学科的区别是文化认知。20世纪认知人类学的发展一般可以分为如下阶段:50年代是“民族科学”的早期形式化阶段;60年代是研究民俗模式的普遍认同的中期阶段;70年代以后是科学化阶段,形成心理学的转向,也吸收了结构主义和语言学的理论要素和方法论;80年代是文化先验图式研究和共识理论的发展阶段;90年代开始的文化认知与进化理论阶段,主要有关联理论(relevance theory)等。当代认知人类学试图发现人类行为的文化认知基础以及激发人类行为的深层致序原理(行为动机)。人工智能无疑涉及这一层面,因而也正在成为认知人类学的重要研究领域。当前认知人类学的研究领域(详见表2)主要包括语义学、知识结构、模式和系统以及话语分析,这些均与人工智能关联密切。

借鉴人工智能和认知心理学,认知人类学曾提出3个模型[33]:其一,信息过程模型(information-processing models),探讨人工智能架构的一般原则及其对人类认知的影响,如“并行分布处理”(PDP)和“联接式处理”(connectionism)。其二,认知发展模型(cognitive-developmental models),重在对不同文化进行比较,发现共同的认知发展轨迹。其中,列维-斯特劳斯的结构主义试图发现人类的心智结构(mantel structure)——不是现象的共同,而是深层认知机制的共同。[34]比如著名的“二分模式”,以及关于神话和亲属制度的结构研究,都是文化认知的心智结构。其三,感知经验模型(perception and experiential models ),认为在环境中共享感知过程和经验会形成跨文化的认知模式。其中,拉科夫(G. Lakoff)和约翰逊(M. Johnson)主张“不受主观主义和客观主义概念陷阱影响的经验现实主义(experiential realism)”,强调身体活动及其在空间的位置产生了知识结构与推理模式,其主要方式是通过基本的生理体验产生系统性结构化的隐喻(意义体系),例如“上”“下”。[35]除上述3个认知人类学模型外,“文化认知模型”是探讨研究人工智能的重要路径,应给予重视。

结论

从认知人类学的视角出发,人工智人发展的核心问题可以表述为:“人工智人”以何为人?何以为人?人工智能的“二次性问题”——包括二次思维、二次意识、二次语言、二次文化等,本来是人工智人为人的基础,目前却逐渐成为人类的挑战,挑战着现有的社会价值和结构。在机器通过人工智能走向人工智人的同时,人工智能带来的标准化、去文化、去主体性以及最终的去人性,使得人类正在走向人类机器。人工智能“文化”是人类社会之脑,一方面,要约束人工智人,防止人工智人以“科技暴力”统治并“文化”人类;另一方面,基于人类学本体论转向的文化认知,不是应将人工智人简单视为一种工具,而是应把其当作“人”,约束并规范其成为有文化、有伦理的人。由此人工智人才能与人类长久和平共生。

盲目的人工智人恐惧症不利于人工智能的发展。我们应清醒地认识到:人工智能依然是人类社会文化结构的投射。在人工智能武器、人工智能违法、人工智能道德败坏等负面情况的背后,本质上依然是人类社会中资本、权力、战争、贪婪等在起作用,前者是后者的反映。人工智能反噬只不过是现实社会“上梁不正下梁歪”的科技推手。因此,在人工智能发展的同时,在对人工智人进行伦理道德和文化赋权的同时,反省人类自己的社会文化结构以及伦理道德缺失,才是人工智能与人类和平共生的深层基础。

注释

[1]尤瓦尔·赫拉利:《人类简史:从动物到上帝》,林俊宏译,北京:中信出版社,2014年。

[2]《谷歌突然宣布:上帝的密码防线逐渐崩溃!人工智能有可能是人类文明史的终结!》,2021年12月4日,https://www.sohu.com/a/505156893_686587。

[3]骆利群:《为何人脑比计算机慢1000万倍,却如此高效?》,2018年5月30日,https://zhuanlan.zhihu.com/p/37485630。

[4]参见L. G. Luo, "Architectures of Neuronal Circuits," Science, 2021, 373, p. 6559.

[5]J. Aru; M. E. Larkum; J. M. Shine, "The Feasibility of Artificial Consciousness Through the Lens of Neuroscience, Trends in Neurosciences", 18 Oct 2023, https://doi.org/10.1016/j.tins.2023.09.009.

[6]P. Butlin; R. Long; E. Elmoznino; Y. Bengio et al., "Consciousness in Artificial Intelligence: Insights From the Science of Consciousness," 22 Aug 2023, https://arxiv.org/pdf/2308.08708.pdf.

[7]Y. Bengio; G. Hinton; A. Yao, et al., "Managing AI Risks in an Era of Rapid Progress," https://doi.org/10.48550/arXiv.2310.17688;也参见何怀宏:《GPT的现实挑战与未来风险——从人类的观点看》,《探索与争鸣》, 2023年第6期。

[8]圆桌:《潘多拉魔盒还是文明利器——大文明视野中的ChatGPT反思》,《探索与争鸣》,2023年第5期。

[9]周剑铭、柳渝:《两种“两种文化”交汇中的人工智能》,《科学与社会》,2018年第1期。

[10]B. Singler, "The AI Creation Meme: A Case Study of the New Visibility of Religion in Artificial Intelligence Discourse," Religions, 2020, 11(5), p. 253.

[11]R. M. Geraci, "Apocalyptic AI Religion and the Promise of Artificial Intelligence," Journal of the American Academy of Religion, 2008.

[12]《全球首个“数字人类”曝光!意识在云端永生》,2019年8月29日,https://www.washingtonpost.com/technology/2019/08/29/hey-google-let-me-talk-my-departed-father/。

[13]约翰·华特生选编:《康德哲学原著选读》,韦卓民译,北京:商务印书馆,1987年,第89页。

[14]V. W. Turner, Dewey, Dilthey, and Drama: An Essay in the Anthropology of Experience, The Anthropology of Experience, V. Turner & E. M. Bruner(eds.), Champaign: University of Illinois Press, 1986, p. 33.

[15][19]张小军、杨宇菲:《人工智能感官的主体性:感观人类学视角的思考》,《中央民族大学学报》,2020年第2期。

[16]伽达默尔:《真理与方法》,洪汉鼎译,北京:商务印书馆,2007年。

[17]张小军、木合塔尔:《走向“文化志”的人类学:传统民族志概念反思》,《民族研究》,2014年第4期。

[18]金观涛,《反思“人工智能革命”》,《文化纵横》,2017年第4期。

[20]姚庚君:《用麦克卢汉的“媒介延伸论”及其现象学哲学基础审视“人工智能威胁论”》,《硅谷》,2015年第05期。

[21]怀特:《文化科学——人与文明的研究》,曹锦清等译,杭州:浙江人民出版社,1988年。

[22]《清华大学社科院课题组:抖音算法提供多元信息,95%用户选择开启个性化推荐》,2023年1月19日,https://www.163.com/dy/article/HRFJ0TSK0519C6T9.html。

[23]J. H. Piao; J. Z. Liu; F. Zhang; J. Su and Y. Li, "Human–AI Adaptive Dynamics Drives the Emergence of Information Cocoons," Nature Machine Intelligence, 09 Oct 2023, https://www.nature.com/articles/s42256-023-00731-4.

[24]严飞:《我们如何逃脱算法营造的信息茧房?》,2022年12月14日,https://www.sohu.com/a/438231008_114988;《清华大学社科院课题组:抖音算法提供多元信息,95%用户选择开启个性化推荐》,2023年1月19日,https://www.163.com/dy/article/HRFJ0TSK0519C6T9.html。

[25]陶庆:《新政治人类学与国家–社会关系》,北京:社会科学文献出版社,2018年。

[26]《曾扬言要摧毁人类的机器人索菲亚,拥有沙特公民身份后,如今怎样?》,2023年9月7日,https://www.sohu.com/a/713867585_121161354。

[27]埃德加·莫兰:《伦理》,于硕译,上海:学林出版社,2017年。

[28]B. Latour, Reassembling the Social, New York: Oxford University Press, 2005.

[29]布鲁诺·拉图尔:《我们从未现代过:对称性人类学论集》,刘鹏、安涅思译,上海文艺出版社,2022年。

[30]Eduardo Viveiros de Castro, "Cosmological Deixis and Amerindian Perspectivism," The journal of the Royal Anthropological Institute, 1998, 4(3), pp. 469–488;爱德华多·科恩:《森林如何思考:超越人类的人类学》,毛竹译,上海文艺出版社,2023年。

[31]W. H. Goodenough, "Cultural Anthropology and Linguistics," Georgetown University Monograph Series on Languages and Linguistics, 1957, 9, pp. 167–173; W. Strurteant, "Studies in Ethnoscience," American Anthropologist, 1964, 66(2), pp. 99–131.

[32]克利福德·格尔茨:《烛幽之光:哲学问题的人类学省思》,甘会斌译,上海世纪出版集团,2013年,第189页。

[33]T. Barfield, The Dictionary of Anthropology, Oxford: Blackwell Publishers Ltd, 1997, pp. 67–69.

[34]克洛德·莱维–斯特劳斯:《结构人类学》,谢维扬译,上海译文出版社,1995年。

[35]G. Lakoff and M. Johnson, Metaphors We Live By, Chicago: University of Chicago Press, 1980.